Todos los buscadores por mencionar los más conocidos cómo Google, Bing, Yahoo, utilizan un programa que a diario va indexando millones de sitios web buscando todo tipo de contenido de acuerdo al tipo de bot la mayoría se encarga de indexar por ejemplo; contenido nuevo escrito en tu web, imágenes y enlaces.

A este software se le denomina de diferentes formas como bot, robots, araña, crawler, etc. En el caso de Google, su robot principal se le conoce como Googlebot.

Índice de contenido

¿Por qué es tan necesario crear un archivo robots.txt en WordPress?

Un archivo de esta naturaleza en tan necesario porque uno de tus objetivos es mejorar tu posición SEO en los motores de búsqueda, dependiendo de la temática de tu sitio web, este facilita la indexación indicándole a los bots que es lo que no deben rastrear.

Hay que mencionar, además que si enviaste la url del Sitemap.xml de tu sitio a Google y Bing o a cualquier otro motor de búsqueda para que empiecen a indexar tu contenido, no es necesario que indiques la url en el fichero robots.

Si la indicas cualquier bot puede tener acceso a el y ver lo que quieres indexar, puede que te interese que otros buscadores no tan famosos como (Google o Yahoo) accedan a el, si quieres que eso pase puedes indicarle la URL del sitemap en este archivo para facilitarles la tarea, ya depende de tus objetivos.

Además el fichero robots.txt te permite denegar o permitir el acceso a determinados bots o impedir que algún contenido de ciertas carpetas sea indexado.

Cuando un bot llegue a tu web este comprobara si existe el archivo robots.txt, y si ese es el caso, seguirá las instrucciones que ahí se le indiquen para analizar la información, si bien ese el funcionamiento general de la mayoría de los bot, hay que tener en cuenta que no todos respetaran esas reglas.

Como todos sabemos hay personas que se dedican a fines pocos éticos como el SPAM, etc., muchos de ellos utilizan sus propios bots para captar cualquier tipo de información de una web y darle un mal uso, saltándose cualquier regla escrita en el fichero robots.txt.

Por eso es importante no colocar información comprometedora en el archivo robots y proteger la información privada con contraseñas que sean lo suficientemente seguras.

Tengo que mencionarte además para que tengas una idea que no solo hay 5 bots, existen más de un Millón de bot (arañas) que cada día están indexando todo tipo de información y el número quizás seguirá aumentando, es casi imposible bloquearlos a todos y no todos pasaran por tu web.

Pero creando un archivo robots.txt podrás establecer reglas que permitan límites para esos bots para que no afecten el SEO de la web y a su vez evitar que los recursos del servidor no se vean comprometidos por “exceso de visitas”, ya que algunos bots consumen muchos recursos.

Cómo crear el archivo robots.txt en WordPress

Crear el archivo robots.txt es sumamente fácil y son 3 las maneras en la que lo puedes crear:

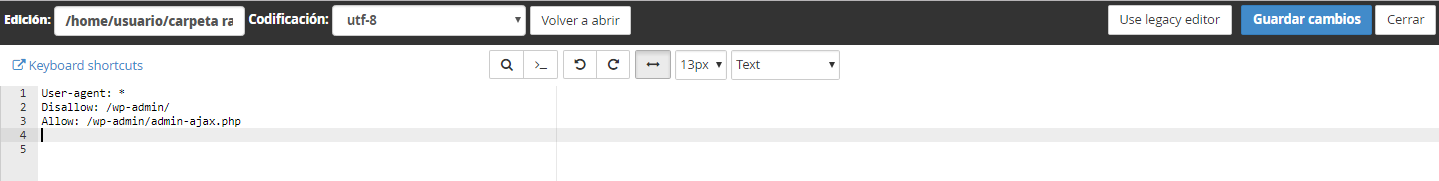

#1 – Utilizando el editor de texto del hosting:

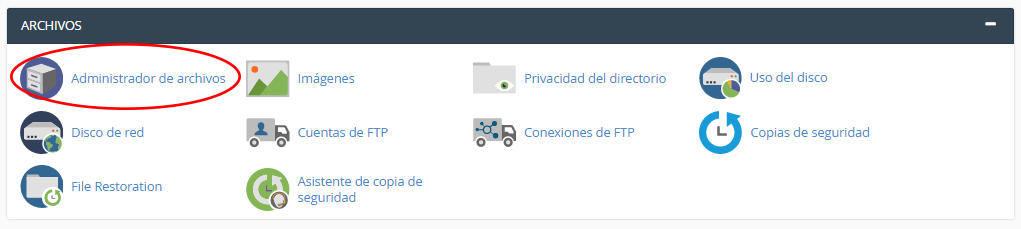

Accediendo al cPanel ubicando la categoría ARCHIVOS, luego hacemos clic en la opción Administrador de archivos.

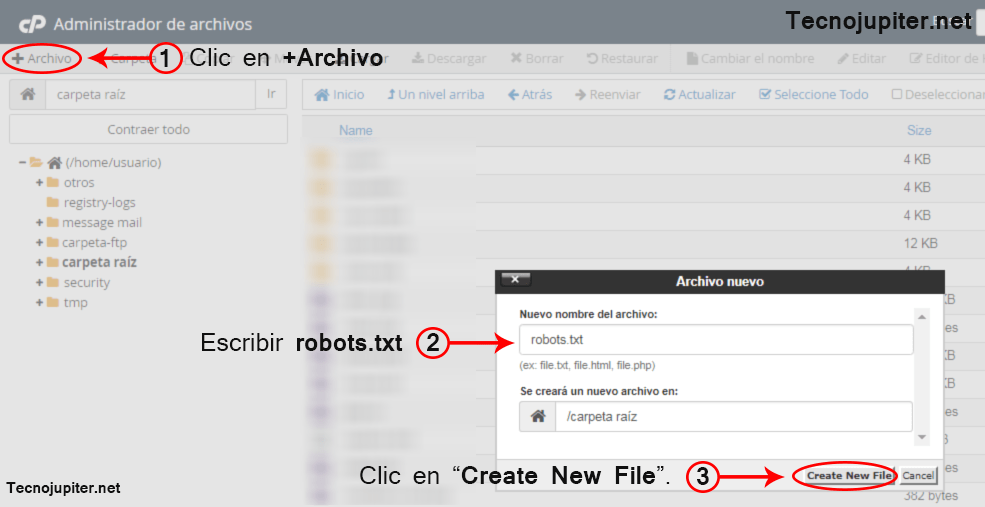

Nos ubicamos en la carpeta raíz o directorio raíz de nuestro sitio web y hacemos clic en la opción +Archivo para crear un archivo nuevo, se abre la ventana y escribimos el nombre robots y la extensión de formato final que es .txt luego clic en el botón «Create New File«.

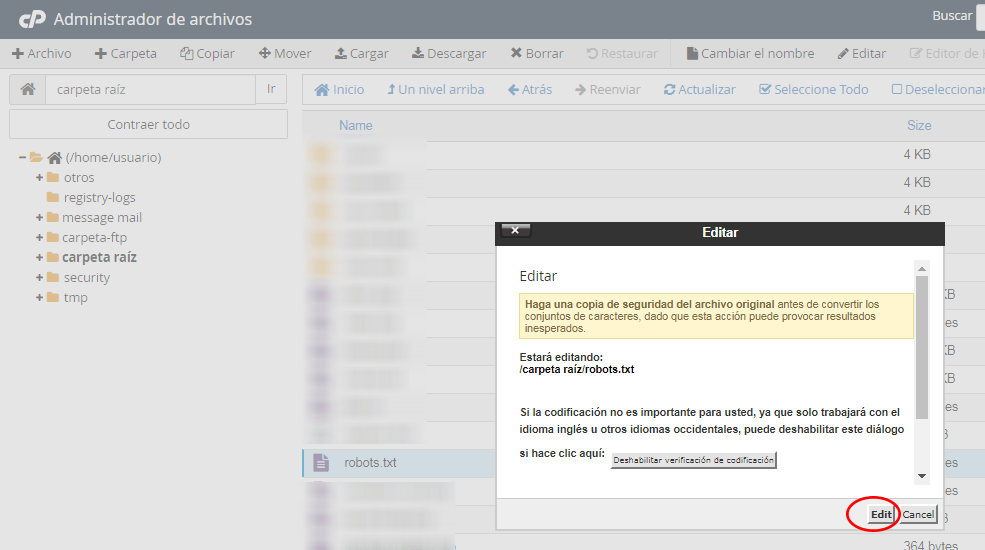

Ya creado el robots.txt este aparecerá en la carpeta raíz hacemos clic derecho en el y luego clic en la opción «Edit» para agregar los comandos y parámetros.

Escribimos:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Que es el fichero más simple de robots para WordPress y guardamos los cambios.

Donde;

User-agent: * (Indicamos que estas reglas son aplicables a todos los buscadores).

Disallow: (Indicamos que no indexe o denegamos el acceso a la carpeta o directorio que indiquemos).

Allow: (Se utiliza para permitir el acceso a un directorio especifico que se haya bloqueado con Disallow).

#2 – Con tu editor de texto preferido bien sea el bloc de notas de Windows, Notepad++, etc.

Abriendo un nuevo archivo en el editor de texto y guárdandolo con el nombre robots.txt. Solo tendrás que subirlo al directorio raíz de tu web a través del cPanel o cualquier medio que uses.

#3 – Utilizando el Plugins para SEO Yoast

Si tienes instalado y activo el plugin Yoast SEO, también puedes crear el archivo robots solo debes ir a la sección de “Herramientas” > “Editor de archivos” y crear tu archivo robots.txt.

En la imagen anterior es referencia de ejemplo ya que no existe un robots.txt perfecto porque todo depende de las necesidades de tu web.

Y no quiero indicarte que coloques las típicas lineas que encuentras en otros sitios web como por ejemplo:

User-agent: *

Allow: /wp-admin/admin-ajax.php

Disallow: /wp-admin/

Disallow: /wp-login

Allow: /wp-content/uploads/*

Allow: /wp-content/*.js

Allow: /wp-content/*.css

Allow: /wp-includes/*.js

Allow: /wp-includes/*.css

Disallow: /tag/*/page/

Disallow: /tag/*/feed/

Disallow: /page/

Disallow: /comments/

Disallow: /xmlrpc.php

Disallow: /cgi-bin

Disallow: /author

Disallow: /*replytocom=

Disallow: /wp-content/plugins/

Disallow: /wp-content/themes/

Disallow: /wp-includes/

Que puedan dañar tu estrategia de SEO.

Mencione anteriormente que las lineas más comunes del fichero robots que te encontrabas en un sitio web WordPress eran:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

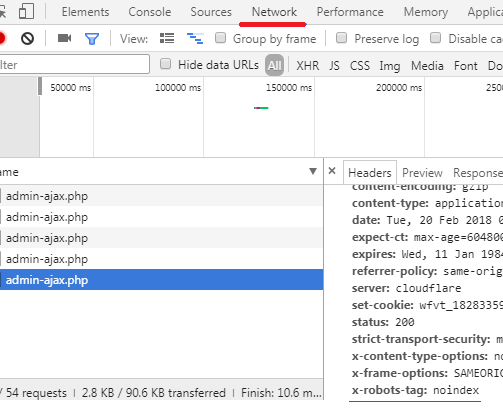

Sin embargo ya esas lineas no son necesarias, porque WordPress ya les esta aplicando Noindex mediante encabezado HTTP de X-Robots-Tag al directorio /wp-admin/admin-ajax.php.

Puedes mirarlo por ti mismo haciendo uso de la consola de herramientas de Google Chrome en el panel de administración de WordPress. Haciendo clic derecho con el mouse en Inspeccionar y luego clic en la pestaña Network.

Como puedes observar esta indicándole a los motores de búsqueda que no rastreen o indexen la página, archivo o directorio particular.

Aún así si deseas seguir usando la directivas puedes hacerlo, pero no tiene sentido que sigas usándola.

Conclusión

Para saber si tienes el archivo robots creado solo tendrás que escribir /robots.txt al final de tu dominio. Por ejemplo: www.tudominio.net/robots.txt

Se recomienda no incluir en un fichero robots.txt más de 100 líneas de Disallow.

La regla Disallow se utiliza cuando se quiera bloquear carpetas completas.

Si es sólo una página suelta, las etiquetas meta «noindex» son más eficaces.

Con el plugin Yoast SEO puedes añadir “noindex” a las páginas que necesites, simplemente yendo a la zona de edición de la página en cuestión y en la caja de Yoast SEO haces clic en el icono, engrane y seleccionas “noindex” en el apartado «Meta robots index» del plugin Yoast SEO.

Para tener una idea de lo que ha indexado Google de nuestra web haga una búsqueda para su sitio así. Escribiendo en la búsqueda “site:www.tudominio.net“.